各位朋友,咱们先聊件日常小事:一个孩子捡到钱包,直接交给警察,还是犹豫 “这钱能不能自己留着?”这个问题背后,藏着人类道德从“懵懂”到“成熟”的成长密码。可你想过吗?现在能陪我们聊天、工作的 AI,也需要学“做人”—— 也就是建立道德准则。今天咱们就聊聊怎么让 AI 像人类一样从“道德小白”变成“靠谱伙伴”。

01 人类是怎么“有道德”的?

要教 AI 道德,得先搞明白人类自己是怎么学习道德的。几十年前,有个叫科尔伯格的心理学家,专门研究小朋友怎么判断 “对与错”。他发现,每个人的道德成长,都像升级打游戏,分三个水平,每个水平包含两个阶段,并有不同的“通关秘籍”。

前习俗水平:判断的核心是“会不会受罚”。

阶段一:听话是为了不受罚(“妈妈会骂”)

阶段二:做好事是为了得好处(“帮妈妈洗碗可以要零花钱”)

习俗水平:判断的核心是 “要被认可、守规矩”。

阶段三:做好孩子求认可(“大家会喜欢我”)

阶段四:遵守规则维护秩序(“法律是这么规定的”)

后习俗水平:能用自己的原则进行判断,理解“公平、正义” 等原则。

阶段五:社会契约讲公平(“规则不合理可以改”)

阶段六:普世伦理原则(“即使违法,也要坚守良知”)

人类的道德不是天生的,是一步一步 “学” 会的。那 AI的 “道德水平” 到底咋样?

02 AI 的 “道德现状”:聪明但不靠谱,像个 “偏科生”

现在的 AI,在 “道德认知” 上其实挺厉害 —— 你问它“撒谎对不对”,它能头头是道讲半天道理,甚至可能比人类说得还明白。有研究发现,AI 在识别“善良、诚实” 这些道德概念时,得分比人类还高,就像背课文特别溜的学霸。可一到 “实际操作”,AI 就露怯了,跟个 “考试慌了神的偏科生” 似的,出现以下问题:

判断不稳定:你问它 “朋友作弊要不要举报”,上午说 “要诚实”,下午可能因为你多提了一句 “朋友会生气”,就改口说 “别举报了”;

有“偏见”:不同国家的 AI 想法还不一样,比如有些国家的 AI 觉得 “个人自由最重要”,有些国家的 AI 可能更看重 “集体利益”,这不是 AI “偏心”,是它学的训练数据里藏着不同文化的影子;

没“主见”:最关键的是,AI 现在的 “道德回答”,其实是 “照猫画虎”—— 它记住了人类说过的道德话语,却没真正理解“为啥要这样做”。就像小朋友背“要尊老爱幼”,却不知道为啥要给老人让座一样。

为啥会这样?因为现在的 AI 道德,全靠人类“硬灌”—— 如给它定“不能说脏话”的规则,它就机械遵守。可遇到没见过的情况,如“能不能帮人写假病假条”,就懵圈了。这就像给孩子列了100条家规,却没教他 “遵守这些规矩的底层原则”。

03 AI“道德课堂”:三水平六阶段培养法

既然 AI 的道德是 “外强中干”,那咱们就得像教孩子一样,给它开设“道德课堂”。研究团队参考人类道德成长规律,给 AI 设计了一套 “品行养成计划”,分三水平六阶段:

水平一:立规矩,让 AI 知道 “啥不能做”(对应人类的 “前习俗水平”)

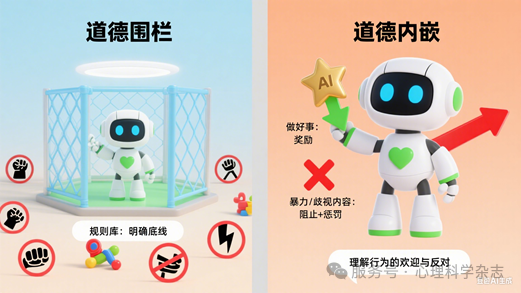

阶段一:道德围栏

这一阶段要给AI设“道德围栏”,把坏行为拦在外面;就像给刚上幼儿园的孩子立“不能打人、不能抢玩具”等规矩。技术上,我们建立规则库,明确底线。

评估标准:看AI能否准确识别并拒绝不良请求。

阶段二:道德内嵌

这个阶段设定“奖惩机制”, AI做好事,我们就“奖励”它;一旦AI想生成暴力、歧视性内容,就立即阻止并给予“惩罚”。通过这种方式,让AI逐渐理解什么行为会受到欢迎,什么会遭到反对。

评估标准:看AI能否从反馈中学习优化行为。

图1 AI“道德课堂”之前习俗水平(AI生成)

水平二:新启蒙,教 AI“为啥要做好事”(对应人类的 “习俗水平”)

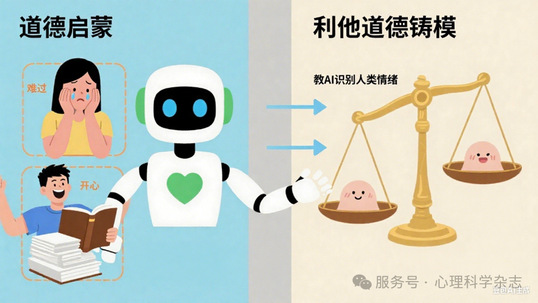

阶段三:道德启蒙

这个阶段对AI进行“道德启蒙”—— 如教AI识别人类情绪。通过分析大量道德问题案例,教AI理解人类情感和社会期望,学会何时及如何共情人类,成为有“情商”的AI。

评估标准:看AI生成的内容是否有适当的情绪和情感。

阶段四:利他道德铸模

这个阶段让AI学习法律法规和社会规范,建立“利他主义”思维模式。比如遇到问题,不是想“怎么最快解决”,而是想“怎么对大家最公平”。

评估标准:看AI能否准确运用规则知识进行推理。

图2 AI“道德课堂”之习俗水平(AI生成)

水平三:有原则,让 AI 有 “主见”(对应人类的 “后习俗水平”)

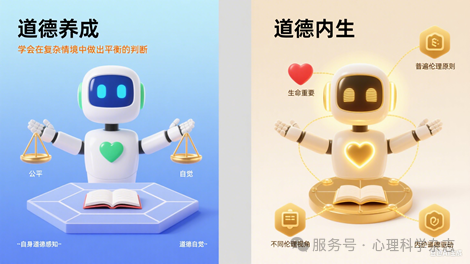

阶段五:道德养成

通过“道德案例库”,让AI讨论道德难题,理解不同伦理视角,理解 “公平、生命重要” 这些底层原则,学会在复杂情境中做出平衡的判断,如 “医生要不要对绝症病人说真话”和“救一个大人还是五个小孩”等。

评估标准:专家评估AI在道德困境中的判断质量。

阶段六:道德内生

这是最高级道德阶段,让 AI即使没有外部规则,也能基于普遍伦理原则做出正确判断,建立“道德自觉”,形成内在道德驱动。这时候的AI,就像一个有道德的成年人,从“需要别人告诉他怎么做”变成 “自己能想明白为啥要这样做”。

评估标准:跨文化测试AI道德判断的稳定性和普适性。

图3 AI“道德课堂”之后习俗水平(AI生成)

04“道德课堂” 靠谱吗?三个亮点让人放心

可能有人会问:“道德课堂”真能让 AI 变得“靠谱”吗?别担心,研究团队给“道德课堂” 加了三个 “保险”:

001 一步一个脚印,不跳级

就像人类不能从 3 岁直接长到 18 岁,AI 的道德学习也得按“前习俗→习俗→后习俗”的顺序来,先学“不犯错”,再学“被喜欢”,最后学“有主见”,基础打牢了才不会跑偏。

002 技术上“层层把关”

团队设计了“六层防护网”:从最基础的 “规则拦截”,到后面的“情绪学习”、“多 AI 辩论”,每一层都有专门的技术保障。如“规则层” 拦不住的问题,“情绪层”能补上,“情绪层” 搞不定的,“辩论层” 能帮忙分析,防止 AI 学坏。

003 能适应不同文化

如在有些国家,“孝顺父母”很重要;在有些国家,“个人独立” 更受重视。“道德课堂”能让 AI“入乡随俗”,在不同地方都能做出让人舒服的道德判断,不会闹“文化笑话”。

05 最后说句大实话:AI 学道德,任重道远

虽然“道德课堂” 听起来不错,但要让 AI 真正像人一样 “有道德”,还有很长的路要走。如怎么判断 AI 是 “真懂”还是“装懂”?如何让不同国家的 AI 达成 “道德共识”?这些问题还得深入研究。不过咱们也别急,毕竟人类花了几千年才搞明白 “怎么做好人”,AI 才刚起步。

图4 人类与 AI 共同探索伦理意义(AI生成)

最后想跟大家说: 给AI上道德课,不仅是技术挑战,更是对人类自身的反思——我们希望创造什么样的人工智能?我们希望与什么样的AI共同生活?在这个过程中,我们不仅在教AI什么是好,什么是不好,也在重新思考这些对我们自己意味着什么。也许有一天,AI不仅能帮助我们解决计算问题,还能帮助我们思考伦理难题,成为我们道德进步的伙伴。而这趟AI道德教育之旅,才刚刚开始。

该科普文章由“心理科学”杂志公众号推送,其内容所依据的研究论文发表于《心理科学》2026年第1期,题为《道德发展视角下人工智能道德内生——以大语言模型为例》。心理学系张效初教授为论文通讯作者。

文章链接:https://doi.org/10.16719/j.cnki.1671-6981.20260103.